Computer haben bekanntlich keine eigenen Gefühle und werden diese auch nicht in absehbarer Zeit entwickeln, doch daran, dass Systeme mithilfe von künstlicher Intelligenz menschliche Emotionen erkennen und deuten lernen kann, wird derzeit im Bereich des Affective Computing geforscht. In einem neuen Forschungszweig werden Erkenntnisse aus der Neurowissenschaft mit Informatik, Psychologie, Soziologie und Kognitionswissenschaft kombiniert. Dabei werden optische, audio-visuelle und physiologische Daten analysiert, um Absichten eines Menschen deuten und ableiten zu können. So sollen damit Smartphones, Wearables und Roboter in die Lage versetzt werden, Emotionen und Gefühle wie Angst, Wut, Freude, oder Trauer zu erfassen, zu analysieren und darauf zu reagieren.

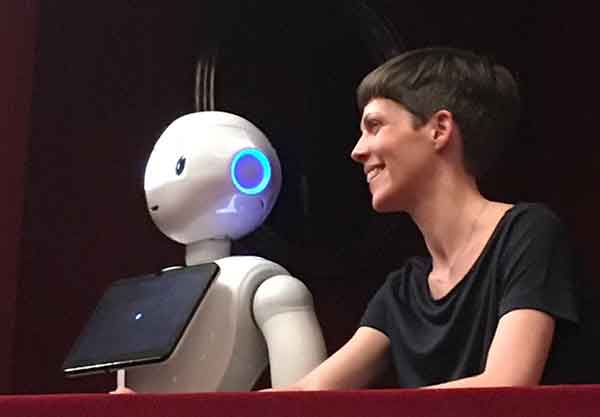

Damit ein Mensch Informationen aufnehmen, verarbeiten und entsprechend Handlungen ableiten kann, greift sein Gehirn auf rund hundert Millionen Neuronen zurück, die in einem komplexen Geflecht miteinander interagieren. Um diesen Prozess auf Systeme künstlicher Intelligenz zu übertragen, arbeitet man mit künstlichen neuronalen Netzen. Diese künstlichen Neuronen dienen als Recheneinheiten, indem sie in Schaltkreisen miteinander verbunden werden, wobei es damm zum Signal kommt, wenn der Input innerhalb eines Schaltkreises einen kritischen Schwellenwert überschreitet. In einem weiteren Schritt kommen spezielle Machine-Learning-Algorithmen zum Einsatz, die die Daten verarbeiten und daraus verwertbare Informationen ableiten. Durch die Identifizierung von Mustern, etwa bei der Analyse von Stimmen oder Gesichtern, innerhalb der gesammelten Daten lassen sich Unterschiede in der Tonlage oder bei Gesichtsausdrücken feststellen. Gleicht man diese mit den zuvor definierten Parametern für verschiedene Emotionen ab, kann die Künstliche Intelligenz Signale zu einer Emotion zusammenfügen und diese deuten. Dadurch kann man bei einer Kombination mit Robotik einen empathischen Assistenten schaffen, der Menschen in unterschiedlichen Lebenslagen unterstützen kann, etwa im Alter, bei Verletzungen oder Krankheit. Roboter und Maschinen werden durch Affective Computing menschlicher, auch weil es den Menschen ein Bedürfnis ist, ihnen auf einer vertrauteren Ebene zu begegnen.

Eva Weber-Guskars Buch »Gefühle der Zukunft« beschäftigt sich mit dem Phänomen des »affective computing« und den mit ihm verbundenen Konsequenzen. Unter »affective computing« versteht man den Versuch, einem Computerprogramm Emotionen beizubringen. Dies schließt das Erkennen, das Hervorrufen und auch die Simulation »echter« Gefühle ein. Die naheliegende Frage nach der grundsätzlichen Möglichkeit einer Maschine, überhaupt Gefühle zu entwickeln, steht hierbei für die Autorin nicht im Vordergrund. Sie geht in ihrem Buch vielmehr der Frage nach, die heutige Gesellschaften ihrer Meinung nach schnellstens beantworten sollten: Wie soll »affective computing« unser Leben beeinflussen?

Eva Weber-Guskars Buch »Gefühle der Zukunft« beschäftigt sich mit dem Phänomen des »affective computing« und den mit ihm verbundenen Konsequenzen. Unter »affective computing« versteht man den Versuch, einem Computerprogramm Emotionen beizubringen. Dies schließt das Erkennen, das Hervorrufen und auch die Simulation »echter« Gefühle ein. Die naheliegende Frage nach der grundsätzlichen Möglichkeit einer Maschine, überhaupt Gefühle zu entwickeln, steht hierbei für die Autorin nicht im Vordergrund. Sie geht in ihrem Buch vielmehr der Frage nach, die heutige Gesellschaften ihrer Meinung nach schnellstens beantworten sollten: Wie soll »affective computing« unser Leben beeinflussen?

Quelle: https://t3n.de/news/emotion-ai-maschinen-lernen-1149606/ (19-03-24)

Nachricht ::: Soziale Robotik ::: Impressum

Datenschutzerklärung ::: © Benjamin Stangl :::